场景解析是指从像素的角度对图像中的不同对象进行分割,并对原始图像中的每个像素进行标注。移动机器人在我们的日常生活中越来越受欢迎,无论是帮助家庭清洁室内的扫地机器人,还是快递仓库分拣和运输货物的物流机器人,以及近年来许多研究者开发的智能巡检机器人,都为人们的日常生活和工业生产提供了帮助。因此,对移动机器人道路上的障碍物进行准确识别是非常重要的。

近年来,国内外许多研究者通过对RGB(red,green,blue,红绿蓝)图像进行解析来识别出目标物体。传统的卷积神经网络存在图像输入大小固定的缺点,为了解决这一问题,Long等[1]用卷积层取代了传统卷积网络背后的全连接层,使网络能够输入任意尺寸的图像。为了解决特征提取中信息丢失的问题,Ronneberger等[2-5]通过设计跳跃连接结构,利用非对称卷积和空洞卷积来产生足够的感受野,设计腹侧路径网络侧重提取语义信息,背侧路径网络侧重提取空间信息等方法来有效地补充特征提取过程中丢失的信息。虽然以上方法都取得了较好的效果,但在遮挡、光照不足等对比度较低的场景下,RGB场景解析方法对分割精度的性能还有待增强。随着技术的进步,深度图因其包含RGB图像所缺少的空间信息而被广泛用于补充RGB图像以提高场景解析的性能。然而,传统的全卷积网络由于感受野有限,在降采样过程中会丢失一部分信息,导致分割精度降低,并且没有充分利用多模态之间的互补性,甚至在交互过程中产生大量的噪声,从而影响分割。为了突破这些限制,研究者们提出了一些方法来增强RGB和深度图两个模态之间的上下文信息和模态交互。Lee等[6-10]通过深度感知传统卷积神经网络(convolutional neural network,CNN)、注意力辅助模块、分离和聚合的门模块、非对称输入流等方法来增强RGB和深度图两个模态之间的特征交互,有效地利用了深度图丰富的空间信息。Lin等[11-14]通过嵌入细节选择模块,从通道和空间两个维度对不同尺度特征依赖进行计算,再通过交换网络分支有选择地使用特征等方法,弥补了RGB和深度信息不同尺度丢失的上下文信息,并对不同尺度的上下文信息进行了增强。

上述研究在场景解析上取得了较好的效果,但是因为受到传统卷积神经网络的限制,对局部信息与全局信息不能有效地进行获取,而变换器模型则能更好地捕获长期依赖关系。针对上述问题,本研究首先通过使用统一变换器(unified transformer,UniFormer)作为主干网络获取特征信息,并通过图卷积来更有效地捕获包含局部信息的高级特征; 然后设计了多模态上下文融合模块(multimodal context fusion module,MCFM)将深度图丰富的空间信息加权给RGB及双向监督模块(bidirectional supervision module,BSM)进行边界和语义信息的双向监督; 最后在机器人行驶路障场景数据集(ground mobile robot perception,GMRP)上进行了评估。

1 B-GCBSNet模型传统的卷积神经网络在训练过程中会丢失部分局部信息,长距离特征捕获能力较为低效,而近年来,变换器模型在图像分割领域的应用结果表明,在特征抽取性能上要优于传统的卷积神经网络; 且卷积神经网络无法处理非欧几里得结构数据,而图卷积的应用则能解决这一方面的不足。因此,本研究提出一种基于边界-图卷积双向监督网络(boundary-graph convolution bidirectional supervised network,B-GCBSNet)以解决传统卷积神经网络存在的问题。

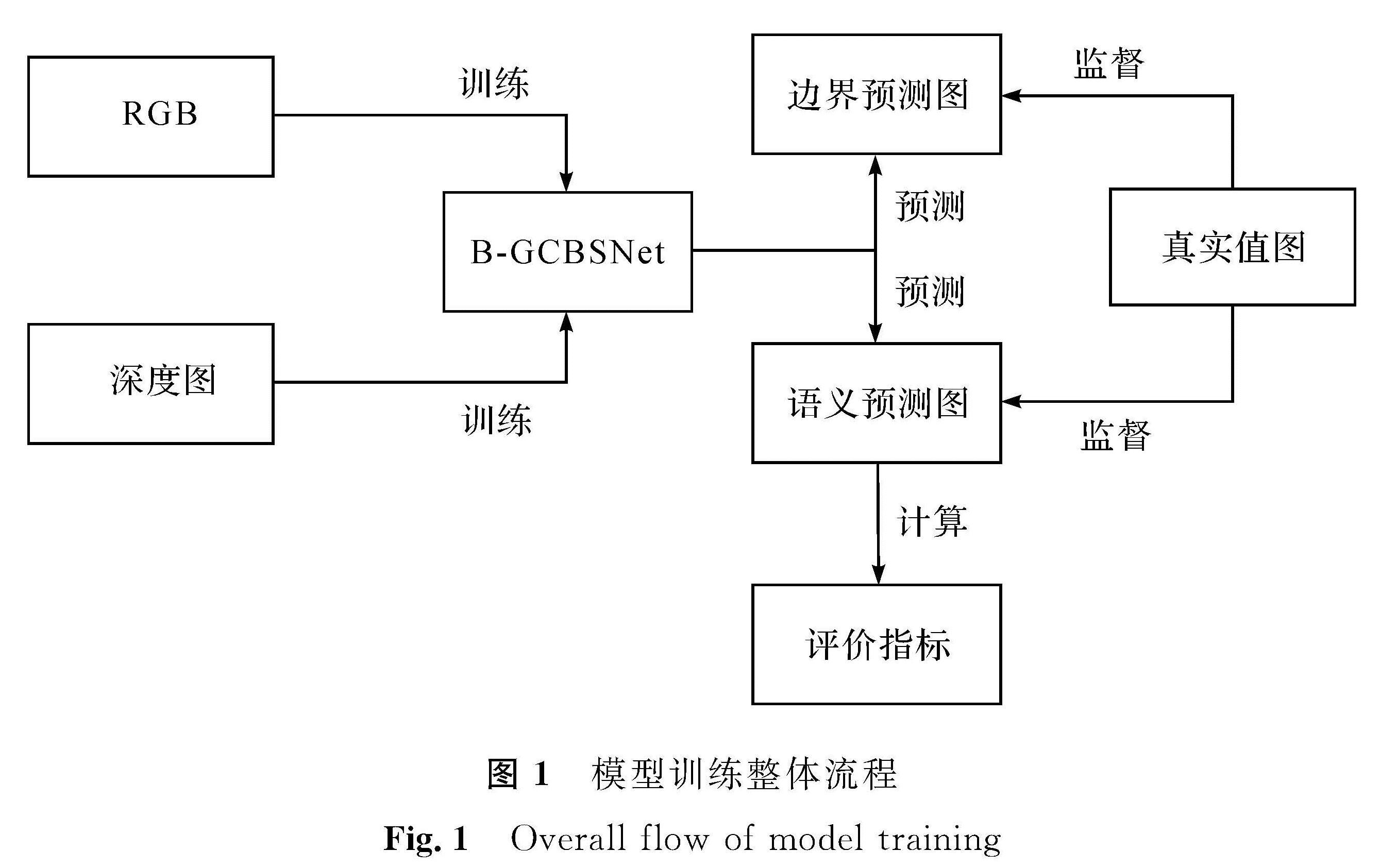

模型训练整体流程如图1所示,将RGB和深度图输入网络中进行训练并得到边界及语义的预测图,在训练过程中通过边界及语义的真实值图对预测图分别进行监督,并通过语义预测图计算评价指标。

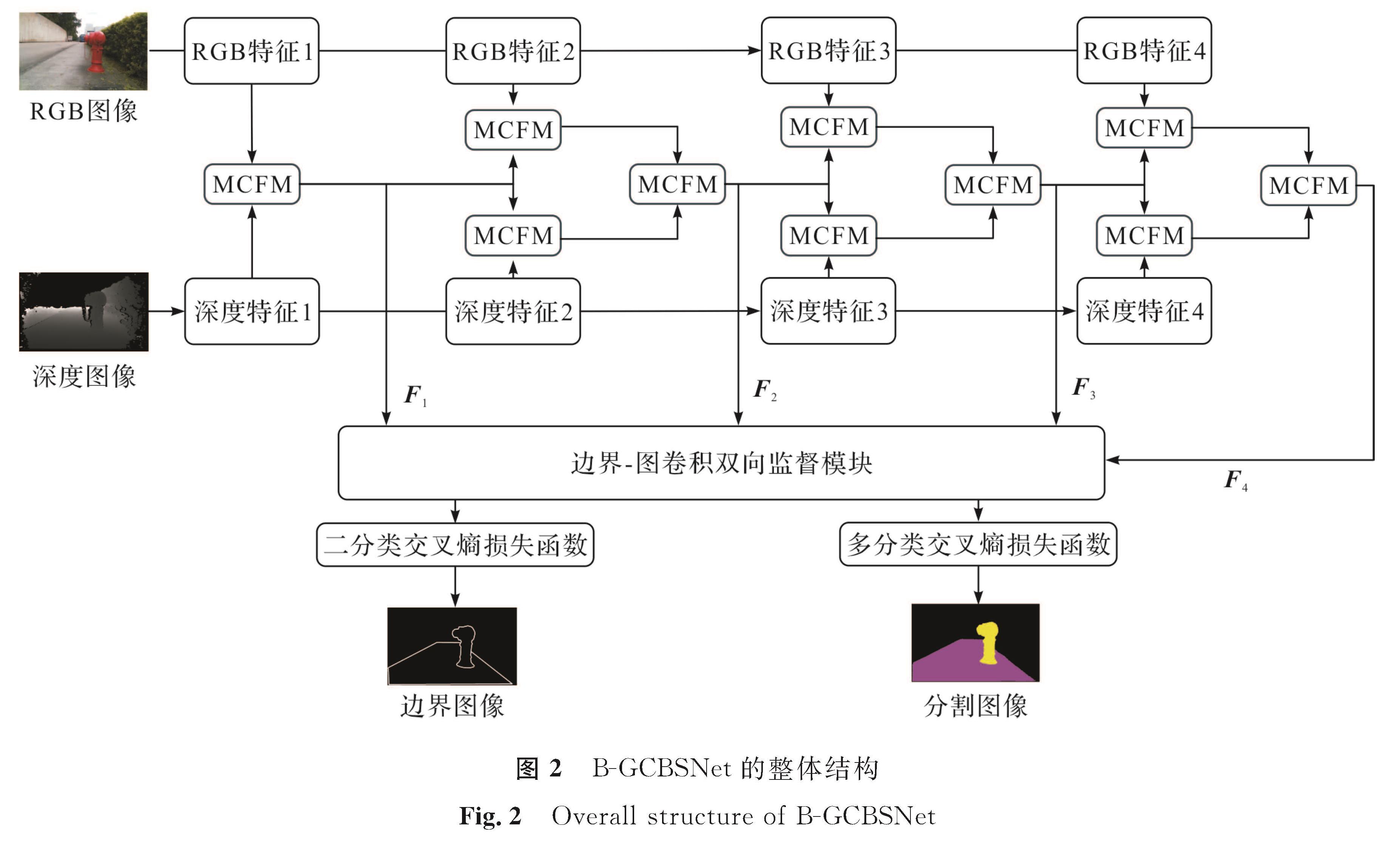

B-GCBSNet的整体结构如图2所示,首先将RGB图像和深度图像分别输入经过预训练的统一变换器中进行训练,分别得到四个阶段的RGB和深度输出特征张量,即图2中的RGB特征(1,2,3,4)和深度特征(1,2,3,4),我们将其分别命名为Ri(i=1,2,3,4)和Di(i=1,2,3,4); 其次将第一阶段的RGB特征和深度特征的输出特征张量输入多模态上下文融合模块中,以利用深度特征包含的丰富空间信息对RGB特征进行信息的补充,并通过增大感受野丰富上下文信息来得到信息增强后的输出特征张量,将该输出经过多模态上下文融合模块分别对下一阶段的RGB图像和深度图像进行信息的补充; 再次将经过信息补充过后的RGB和深度图两个不同模态特征输入多模态上下文融合模块中,得到新的信息增强后的输出特征张量,之后的操作过程与前一阶段一致; 最后利用边界-图卷积双向监督模块对特征进行解码并通过图卷积来丰富特征的全局上下文,输出特征图的边界图像与分割图像结果并进行监督。

1.1 多模态上下文融合模块

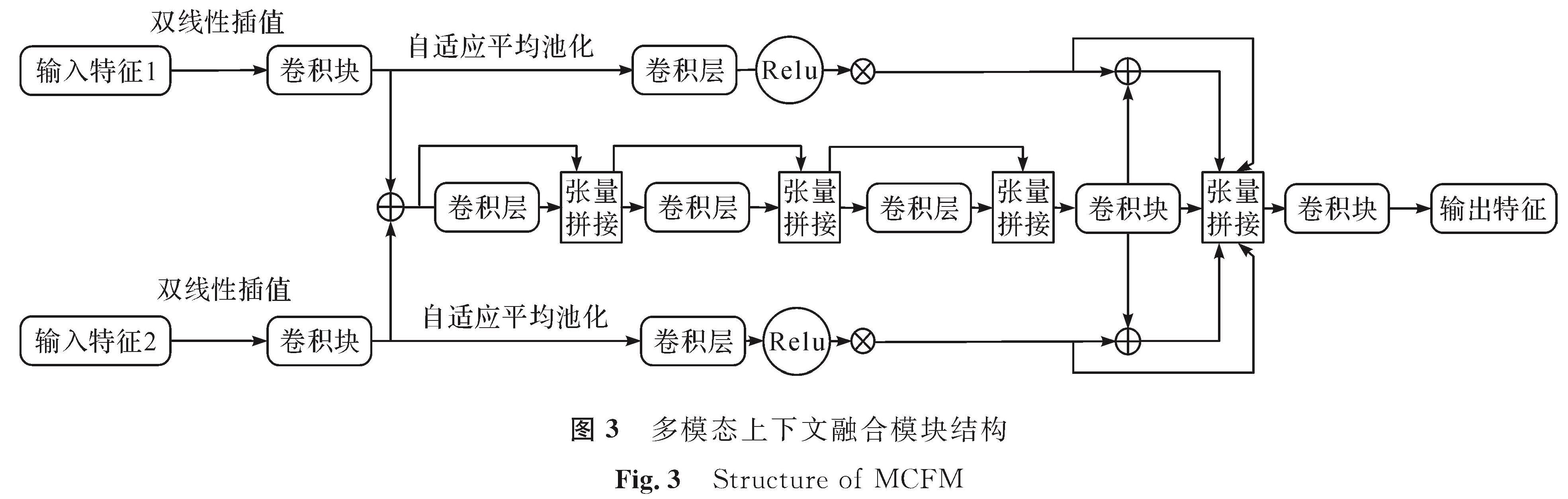

有效地整合上下文信息可以帮助捕捉物体的位置和定位,为此本研究设计了多模态上下文融合模块以有效整合上下文信息,多模态上下文融合模块结构如图3所示。首先通过双线性插值的方式将输入的特征图调整为相同的大小,并通过一个卷积核大小为3的卷积块将通道数调整为相同数量; 然后将RGB和深度图两个模态特征相加得到融合特征图,并将该融合特征图连续经过三层的卷积层来增大感受野以得到更丰富的上下文信息,从而得到范围更广的语义信息及色彩、纹理等细节信息。在这一过程中,还通过残差的方式将上一层的输出和下一层的输出进行拼接以减少信息的丢失,再通过卷积块将通道数调整为输入特征图的大小得到融合分支的输出Mi。需要注意的是,卷积层相比卷积块多出了批量归一化或激活函数的操作,以输入特征为Ri、Di为例,该过程表示如下:

gi=Conv(fb(Ri))+Conv(fb(Di)) (1)

c1=fc(fcbr(gi),gi) (2)

c2=fc(fcbr(c1),c1) (3)

Mi=Conv(fc(fcbr(c2),c2)) (4)

式(1)~(4)中:fb为双线性插值操作; Conv为卷积操作; fcbr由卷积核大小为3的卷积操作、批量归一化操作和Relu激活函数构成; fc表示张量的拼接操作; c1为gi经过fcbr操作后和未经过fcbr操作的gi进行张量拼接后的输出,c2同理。

对于输入特征的两条分支,首先通过自适应平均池化以有效地获取上下文信息,并经过一层卷积层得到新的特征,为了减少计算量,在卷积操作时将输入特征的通道数缩减到了原来的1/16,接着经过Relu激活函数及卷积操作将通道数恢复到原来大小,然后通过Sigmoid激活函数与原始输入进行元素相乘得到加权后的特征图,并分别与Mi相加,最后通过张量拼接操作将特征图进行拼接,并为了降低参数量,通过卷积操作调整通道数大小,得到多模态上下文融合模块的融合特征输出Fi,以Ri、Di输入为例,其计算公式如下:

ri=Ri×σs(Conv(σr(Conv(fap(Ri))))) (5)

di=Di×σs(Conv(σr(Conv(fap(Di))))) (6)

rrd,i=ri+Mi (7)

drd,i=di+Mi (8)

Fi=Conv(fc(Mi,ri,di,rrd,i,drd,i)) (9)

式(5)~(9)中:ri为RGB分支输出; σs为Sigmoid激活函数; σr为Relu激活函数; fap为自适应平均池化操作; di为深度图分支输出; rrd,i和drd,i分别为RGB分支和深度图分支的融合输出。

经过多模态上下文融合模块进行RGB和深度信息的融合后,我们还利用其信息增强后的输出特征分别对下一阶段的RGB和深度信息进行了信息增强; 接着再进行RGB和深度信息两个模态的特征融合,从而得到四个阶段的融合特征输出Fi(i=1,2,3,4)。

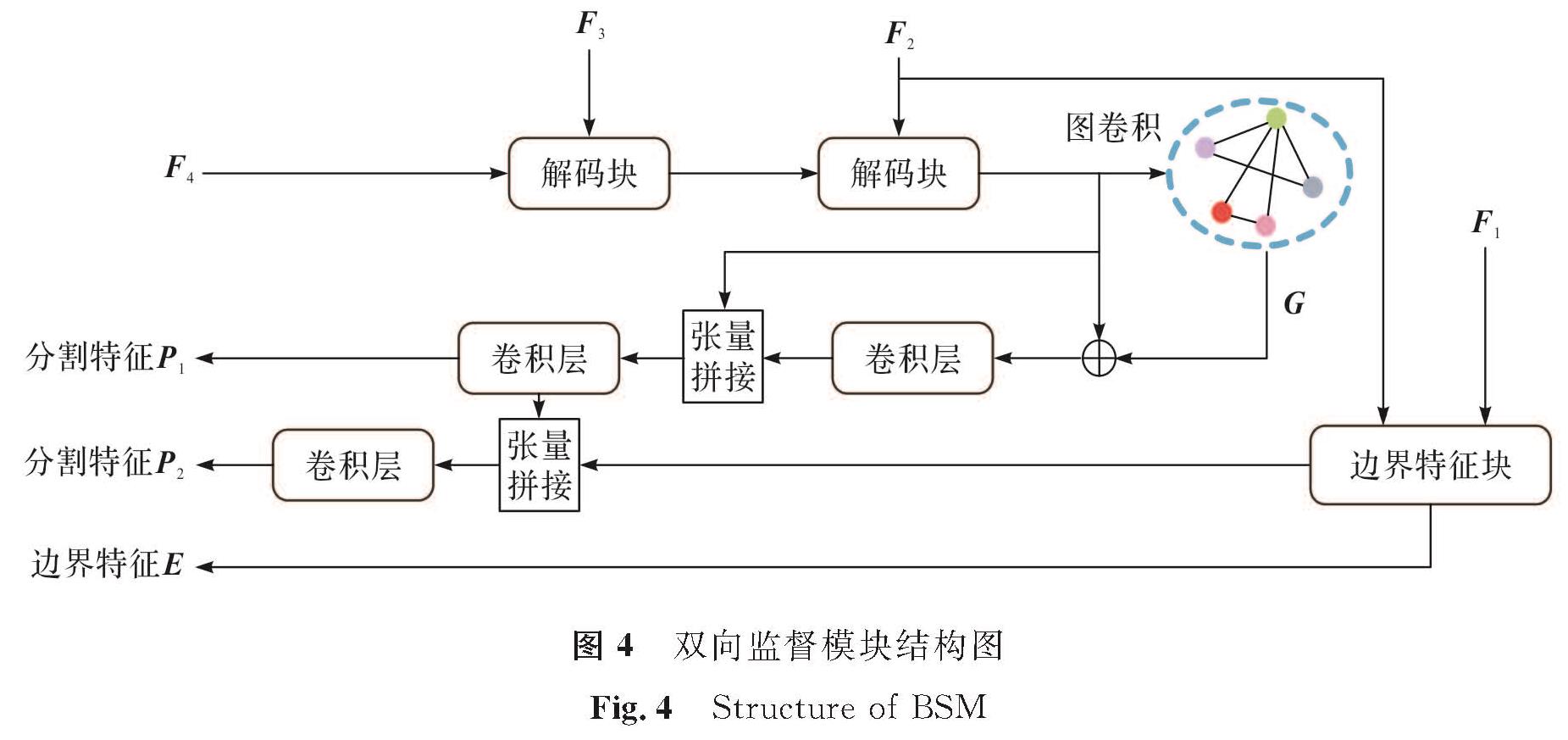

1.2 双向监督模块图卷积在整个图像中全局传播信息,相比基于条件随机场的方法提供了更强的表征能力。提取特征图的边界信息则能更好地校准输出特征的边界像素的准确率,以此来提升最终的分割效果。因此我们设计了利用图卷积增强分割特征并进行监督同时对边界特征进行监督的双向监督模块。双向监督模块结构如图4所示,其中Pi(i=1,2)表示语义分割的输出特征,E表示边界的输出特征,G表示经过图卷积后的输出特征。

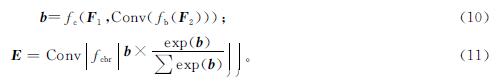

因为低级特征包含更为丰富的全局信息,所以边界信息由前两层低级特征通过边界特征块生成。首先将前两层的融合特征输出F1、F2输入经过一层卷积调整为相同通道数; 然后通过双线性插值调整为相同大小,并通过拼接的方式进行整合; 最后通过卷积层调整通道数得到特征图的边界特征E,其计算公式如下:

对于高级特征,首先通过解码块来进行上采样操作,解码块首先将融合特征Fi输入卷积核为3的卷积层中并通过转置卷积进行上采样。

其次与Fi-1拼接后再经过一层卷积层得到解码块的输出,解码块操作公式如下:

u=fcbr(fc(TransConv(fcbr(Fi)),Fi-1)) (12)

式(12)中:TransConv为转置卷积操作。然后通过图卷积来生成特征的全局上下文,定义输入张量为X∈RN×D,D表示特征维数,N表示特征图高与宽的乘积,图卷积公式定义如下:

G=σ(AXW)。(13)

式(13)中:σ为非线性激活函数; A为描述图的邻域关系的邻接矩阵; W为权值矩阵。

最后将经过图卷积的输出和经过解码块的输出通过元素相加,并通过卷积层和拼接操作之后得到粗略的分割特征图P1; 将P1与边界特征图E通过拼接操作来进行边界的校准,并得到校准后的分割特征图P2。该过程表示如下:

P1=Conv(fc(u,fcbr(u+G))) (14)

P2=Conv(fc(E,P1)) (15)

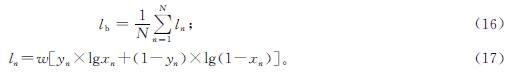

1.3 损失函数本研究的算法分别对边界和语义信息进行了监督。因为边界只包含了边缘及背景,因此使用了二分类交叉熵损失函数lb进行监督,该损失函数计算公式如下:

式(16)~(17)中:N为样本数; yn为标签值; xn为模型预测值; w为权重值。

对分割结果的预测图则采用了多分类交叉熵损失函数lm进行监督。由于有2个监督对象,因此进行了两次交叉熵损失函数的计算,该损失函数计算公式如下:

式(18)中:sgnic为样本i的符号函数,如果样本i的真值等于类别c取1,否则取0; pic为观测样本i属于类别c的预测概率。

2 试验结果与分析2.1 试验数据集与评价指标试验数据来自Wang等[15]提出的机器人行驶路障场景数据集,该数据集涵盖了机器人工作的30个常见场景(例如人行道和广场),以及机器人在真实环境中可能遇到的18种不同的道路异常。数据集包含了3 896张RGB图像,以及对应的深度图像和真实值图。RGB图像的原始大小为1 280×720像素,数据集包括三大类:未标记区域、可行驶区域和道路异常。在试验中,将数据集进行随机分配,其中3 101张作为训练集,420张作为测试集,375张作为验证集。

为了验证模型的可扩展性,我们还在公共数据集纽约大学深度数据集(NYU-Depth V2)上进行了试验。NYU-Depth V2数据集包含1 449张RGB及对应的深度图像和真实值图,其原始大小为480×640像素,包含类别41类。

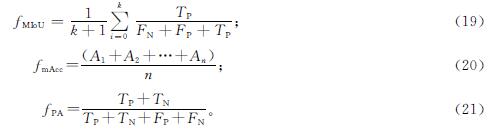

试验选用平均交并比(mean intersection over union,MIoU)和平均类别准确率(mean classification accuracy,mAcc)及像素准确率(pixel accuracy,PA)作为评价指标,计算公式如下:

式(19)~(20)中:TP为真正例; FN为假反例; FP为假正例; TN为真反例; An为第n个类别的准确率。

2.2 试验设置试验使用PyTorch框架实现,并在NVIDIA Titan XP图形处理器上进行训练和测试。在训练过程中,为了减少参数数量和训练时间,将图像的输入尺寸裁剪到384×384像素,批大小设置为3,学习率设置为4e-3,动量设置为0.9,权重衰减为5e-4。网络参数由随机梯度下降优化器进行更新。整个训练在40轮后结束。在训练阶段,还使用了数据增强,包括随机剪切、随机水平翻转、亮度及对比度调整。

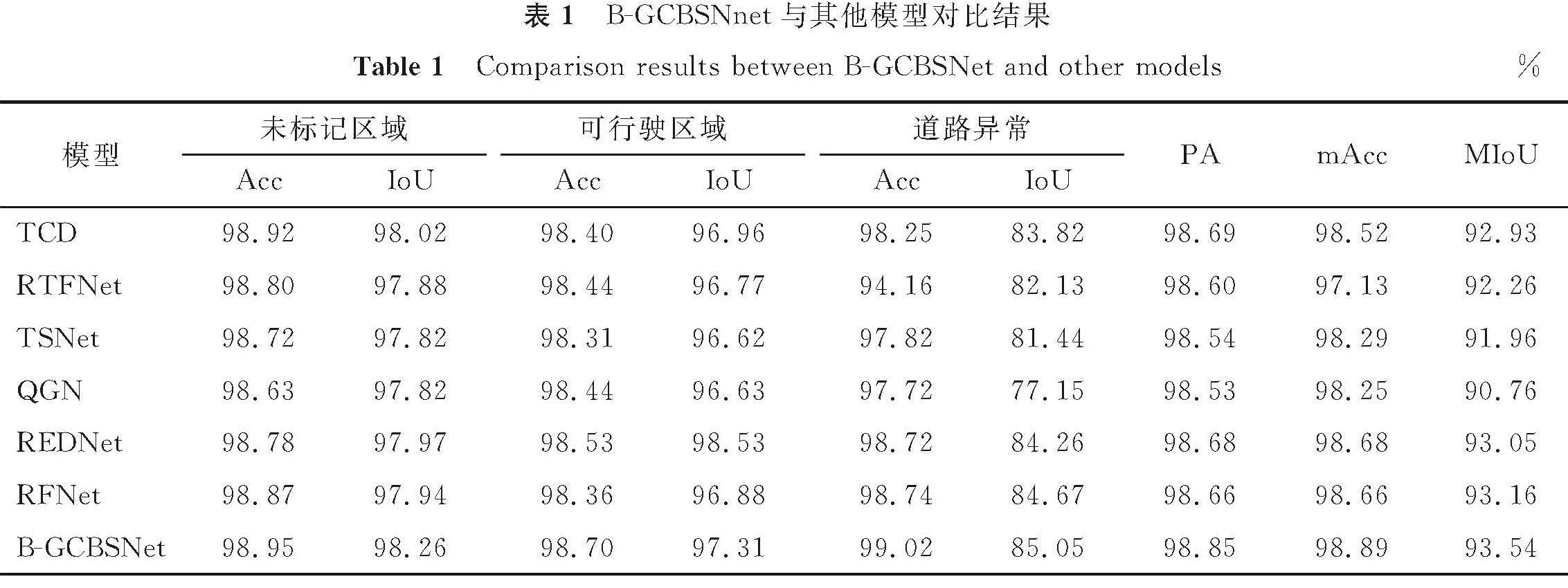

2.3 试验结果与分析将B-GCBSNet与现有先进的6个模型进行了比较,包括两阶段级联解码网络(two-stage cascaded decoder,TCD)、RGB-热力融合网络[16](RGB-thermal fusion network,RTFNet)、三流自注意力网络[12](three-stream self-attention network,TSNet)、四叉树生成网络(quadtree generating networks,QGN)、残差编码解码网络(residual encoder-decoder network,REDNet)和实时融合网络(real-time fusion network,RFNet),以此来验证本模型的有效性。B-GCBSNet与其他模型对比结果见表1。

由表1可知:B-GCBSNet在三个类别上都达到了较好的分割效果,且平均交并比、平均类别准确率和像素准确率都达到了最高。其中红、蓝、绿分别表示排名第1、2、3的结果。

为了更直观地观察B-GCBSNet在分割结果上带来的提升,本研究列举了多个模型与B-GCBSNet在该4张图上的可视化图,其包含了4张图像的RGB图、深度图及真实值图(ground truth,GT),各模型的可视化图比较见图5。由图5可知,B-GCBSNet在预测结果上都最为接近真实值图。从前2张图中可以看到,所有模型都对障碍物(图中黄色部分)出现了分割上的失误,第1张图的柱子的上半部分,因为背景比较复杂,出现了将背景误判为障碍物的情况,也出现了将柱子误判为背景导致柱子不连续的情况; 第2张图的水桶则因为光线较暗,图像较模糊,导致了模型对障碍物的识别产生困难,而B-GCBSNet因为捕获了目标的空间位置信息和更准确的上下文关系,在去除噪声、识别图像中各像素之间的关联性更加有效,因此它在障碍物识别的完整度上达到了最好的效果; 从后2张图则可以看出,对于可行驶区域(图中紫色部分)中笔直凹陷的边界部分,模型对其判断大多是较为光滑的曲线,因为这一段边界像素之间的关联较为模糊,不能准确地进行分割,而B-GCBSNet有对边界信息进行校准,强化了边界部分的区别与联系,因此在可行驶区域的边界判断达到了最好的效果。

2.4 试验消融结果与分析

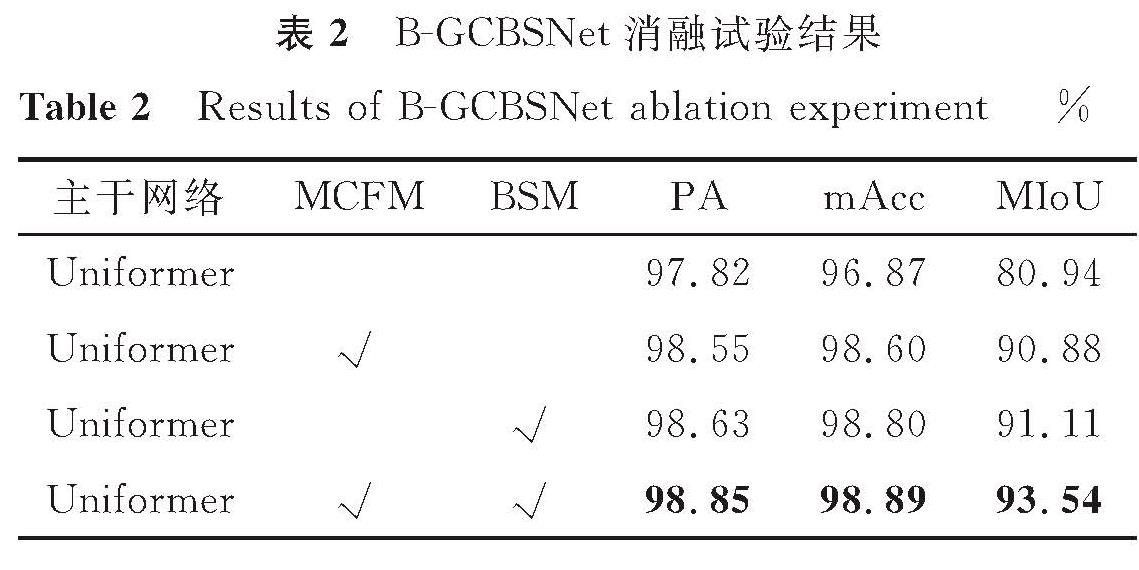

为了验证设计的模块的有效性,本研究对B-GCBSNet进行了一系列消融试验,通过用简单的元素相加来替代原来的模块,其他训练条件与训练完整网络时一致。B-GCBSNet消融试验结果见表2。由表2可知,在去掉了设计的模块后,网络性能有所下降,当仅去除了多模态上下文融合模块(MCFM)时,MIoU下降了2.43百分点,mAcc下降了0.09百分点,PA下降了0.22百分点; 当仅去除了双向监督模块(BSM)时,MIoU下降了2.66百分点,mAcc下降了0.29百分点,PA下降了0.3百分点; 而当去除两个模块,仅使用基础网络进行训练时,MIoU下降了12.6百分点,mAcc下降了2.02百分点,PA下降了1.03百分点。这表明设计的模块是有效的。

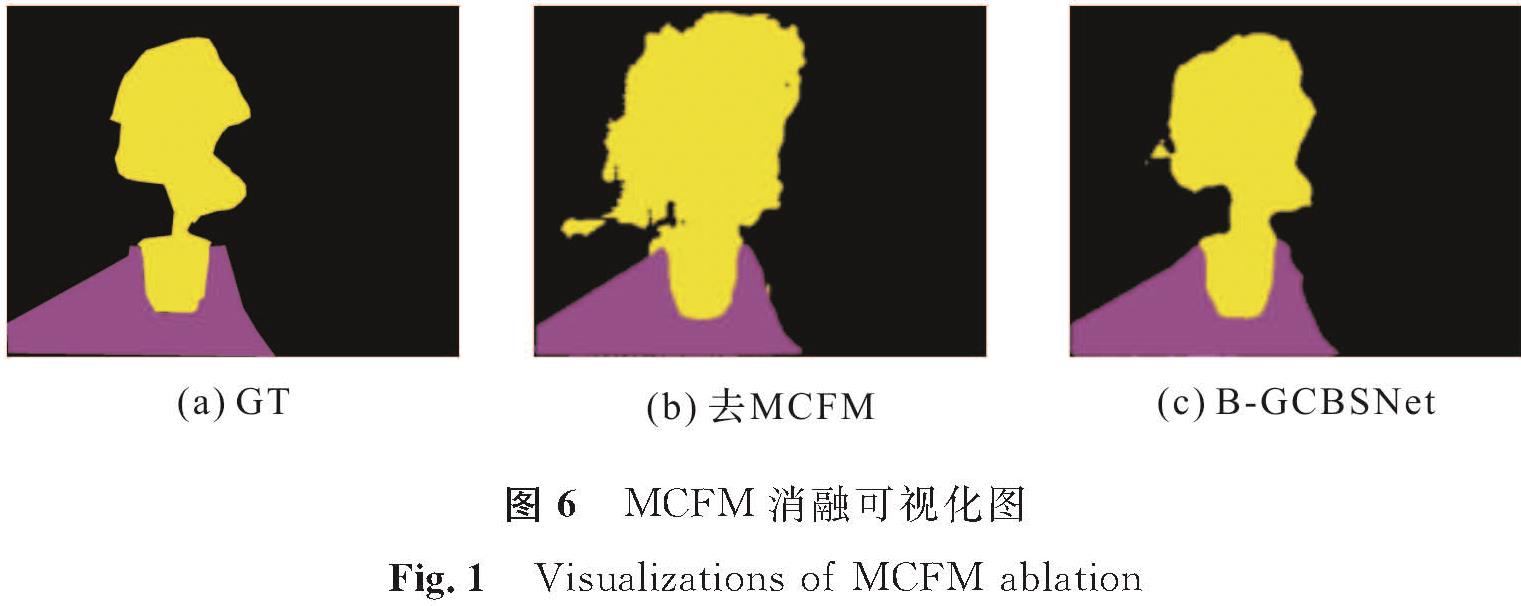

MCFM消融可视化图见图6,由图可知,在去除了多模态上下文融合模块后,预测图将部分背景误判为了道路障碍,对像素之间的关联性出现了大量的误判; 而未去除多模态上下文融合模块的预测图则更为准确地预测出了目标类别。这表明该模块对提取多模态上下文信息的能力更强。

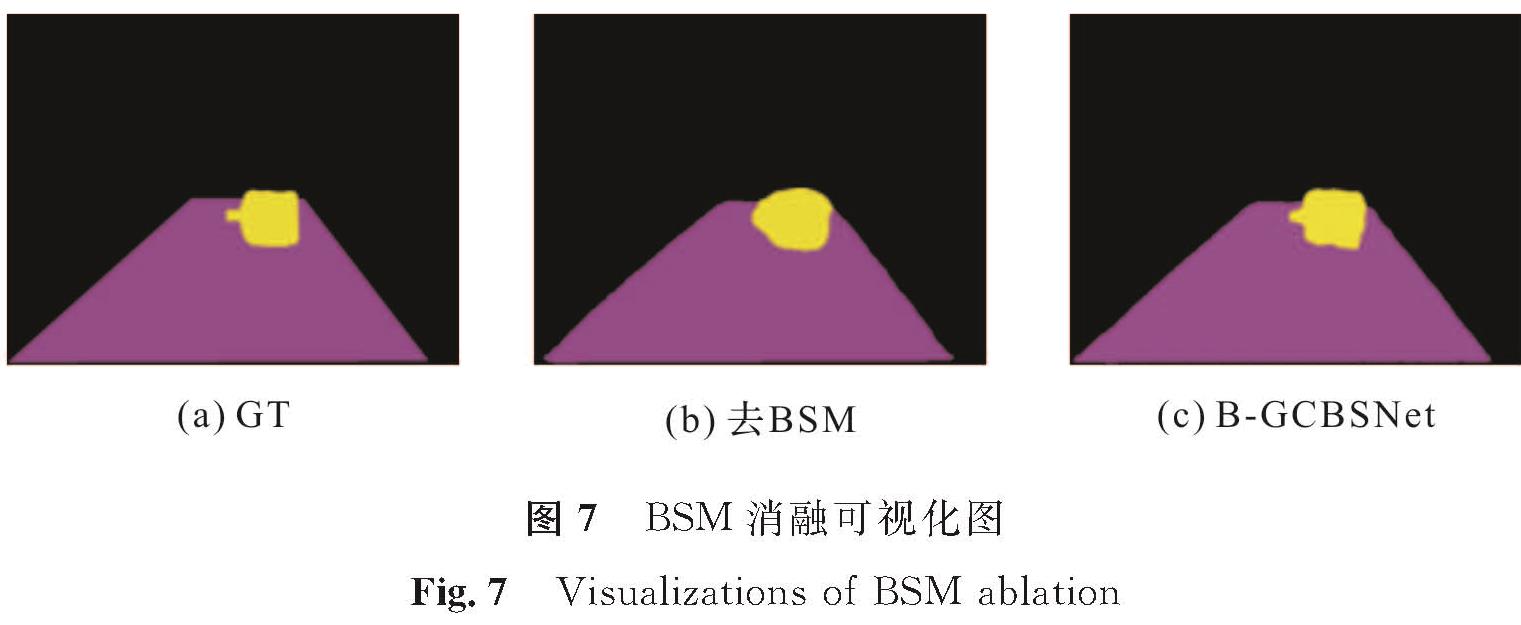

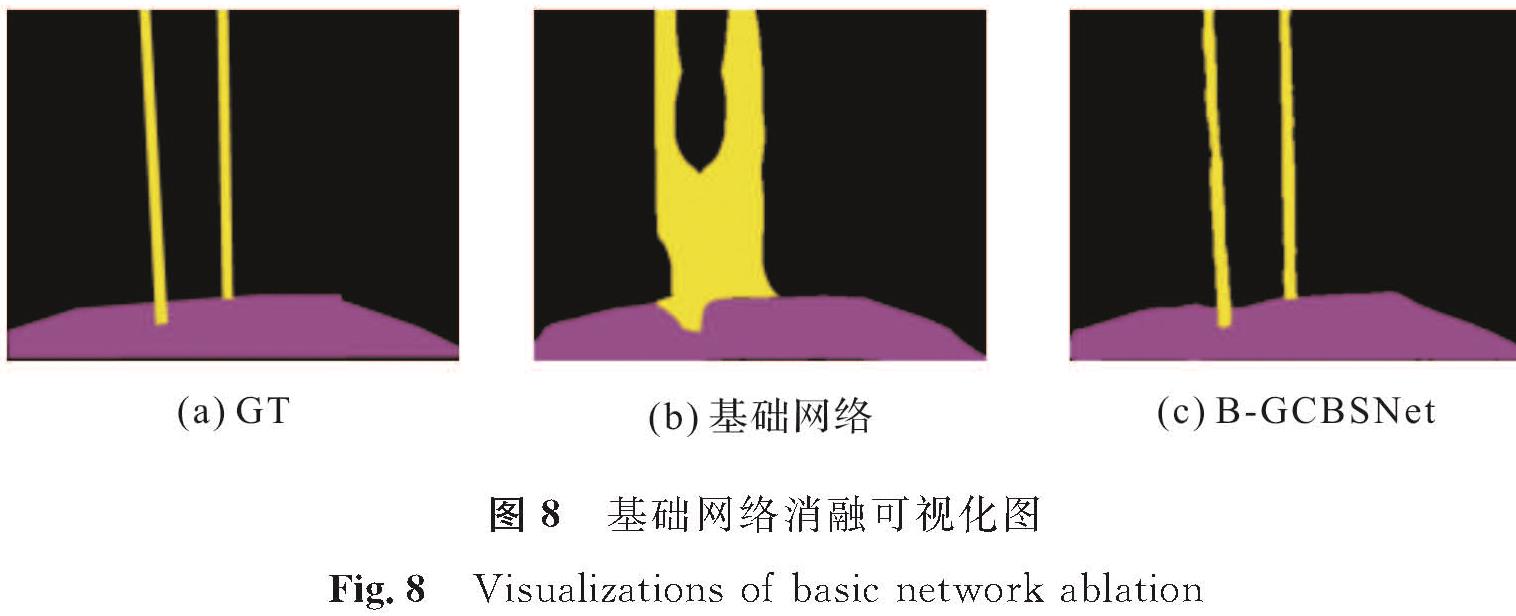

BSM消融可视化图见图7,由图可知,在去除了双向监督模块后,虽然预测图预测出了障碍物的大致方位,但是对其整体形状的判断还是存在着缺陷; 而未去除双向监督模块的预测图则大致预测出了目标物体的整体形状,在轮廓上更为精确。这表明双向监督模块不仅有边界修复能力而且对像素之间的关联性判断也更为准确。

基础网络消融可视化图见图8,由图可知,当仅简单地将RGB和深度图进行相加进行训练时,不论是语义信息还是目标物体的细节都出现了较大的误差,而B-GCBSNet则在语义和细节信息上更接近真实图。这表明B-GCBSNet对分割效果有很大的提升。

2.5 可扩展性分析

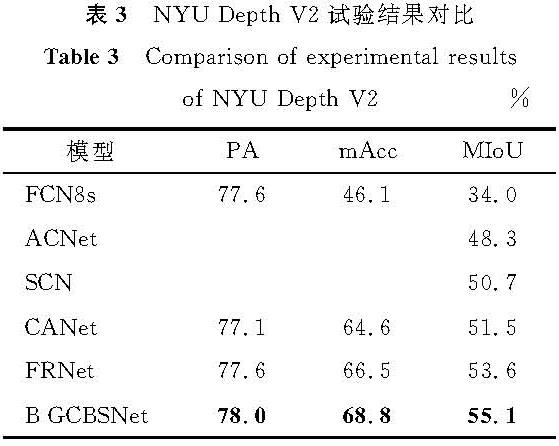

为了验证B-GCBSNet的可扩展性,本研究在公共数据集NYU-Depth V2上进行了试验,并与多个经典模型进行了比较,包括全卷积网络(fully convolutional network,FCN)、基于注意力网络(attention based network,ACNet)、上下文切换网络(switchable context network,SCN)、共注意力网络[17](co-attention network,CANet)和特征重构网络[18](feature reconstruction network,FRNet)。在试验过程中,随机分配795张图像作为训练集,654张图像作为测试集,并将图像大小裁剪为384×384像素。NYU-Depth V2试验结果对比见表3。由表3可知,B-GCBSNet在性能上优于现有先进的方法,这表明本模型具有较强的可扩展性。

3 结 语

本研究针对地面机器人行驶过程中对周围环境感知问题提出了B-GCBSNet模型。基于Uniformer主干网络分别对RGB和深度图进行训练,并在训练过程中将每个阶段的输出特征,通过设计的多模态上下文融合模块,将深度图丰富的空间信息补充给RGB图,通过多尺度补充特征图的上下文信息; 利用双向监督模块分别对特征图的边界及语义特征进行监督。在语义分支,还利用了图卷积来建模特征图的全局信息,补充了下采样过程中丢失的信息。在一个地面机器人行驶道路数据集上对B-GCBSNet进行了测试,并与多个先进的模型进行了比较,结果表明,B-GCBSNet在性能上达到了最优。为了验证模型的可扩展性,还在NYU-Depth V2数据集上进行了试验,结果表明B-GCBSNet依旧具有良好的性能。在未来的工作中,我们将会重点研究如何在保证准确率的情况下,降低网络的复杂性,以实现实时性能,方便实际应用。

- [1] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):640.

- [2] RONNEBERGER O, FISCHER P, BROX T. U-Net:convolutional networks for biomedical image segmentation[C]//Proceedings of the International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham:Springer,2015:234.

- [3] LI G, YUNI, KIM J, et al. DABNet:depth-wise asymmetric bottleneck for real-time semantic segmentation[C]//Proceedings of the British Machine Vision Conference. Cardiff:University of Cardiff,2019:11357.

- [4] HOU Q B, ZHANG L, CHENG M M, et al. Strip pooling:rethinking spatial pooling for scene parsing[C]//Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Seattle:IEEE/CVF,2020:4003.

- [5] WU Y, HUANG Z M, LONG H Y, et al. A semantic segmentation network simulating the ventral and dorsal pathways of the verebralvisual cortex[J].IEEE Access,2021,9:47230.

- [6] LEE S, PARK S J, HONG K S. RDFNet:RGB-dmulti-level residual feature fusion for indoor semantic segmentation[C]//Proceedings of the International Conference on Computer Vision. Venice:IEEE,2017:4980.

- [7] WANG W Y, NEUMANN U. Depth-aware CNN for RGB-D segmentation[C]//Proceedings of the European Conference on Computer Vision. Munich:Springer,2018:135.

- [8] HU X X, YANG K L, FEI L, et al. ACNet:attention based network to exploit complementary features for RGB-D semantic segmentation[C]//Proceedings of the International Conference on Image Processing. Taipei:IEEE,2019:1440.

- [9] CHEN X K, LIN K Y, WANG J B, et al. Bi-directional cross-modality feature propagation with separation-and-aggregation gate for RGB-d semantic segmentation[C]//Proceedings of the European Conference on Computer Vision. Glasgow:Springer,2020:561.

- [10] ZHOU W J, YUAN J Z, LEI J S, et al. TSNet:three-stream self-attention network for RGB-D indoor semantic segmentation[J].Intelligent Systems,2021,36(4):73.

- [11] LIN D, ZHANG R M, JI Y F, et al. SCN:switchable context network for semantic segmentation of RGB-D images[J].IEEE Transactions on Cybernetics,2020,50(3):1120.

- [12] YUE Y C, ZHOU W J, LEI J S, et al. Two-stage cascaded decoder for semantic segmentation of RGB-D images[J].IEEE Signal Processing Letters,2021,28:1115.

- [13] SUN L, YANG K L, HU X X, et al. Real-time fusion network for RGB-D semantic segmentation incorporating unexpected obstacle detection for road-driving images[J].IEEE Robotics and Automation Letters,2020,5(4):5558.

- [14] 杜敏敏,司马海峰.改进DeepLabv3+的道路图像语义分割网络[J].中国科技信息,2022(15):105.

- [15] WANG H L, FAN R, SUN Y X, et al. Dynamic fusion module evolves drivable area and road anomaly detection:a benchmark and algorithms[J].IEEE Transactions on Cybernetics,2022,52(10); 10750.

- [16] SUN Y X, ZUO W X, LIU M. RTFNet:RGB-thermal fusion network for semantic segmentation of urban scenes[J].IEEE Robotics and Automation Letters,2019,4(3):2576.

- [17] ZHOU H, QI L, HUANG H, et al. CANet:co-attention network for RGB-D semantic segmentation[J].Pattern Recognition,2022,124:108468.

- [18] ZHOU W J, YANG E Q, LEI J S, et al. FRNet:feature reconstruction network for RGB-D indoor scene parsing[J].IEEE Journal of Selected Topics in Signal Processing,2022,16(4):677.

图 1 模型训练整体流程

Fig.1 Overall flow of model training

图 1 模型训练整体流程

Fig.1 Overall flow of model training