灰狼优化算法(grey wolf optimization,GWO)是由Seedily Mirjalil等人提出的一种群体智能优化算法[1],具有原理简单、调整参数少和易于实现等优点,被广泛应用于电力系统优化[2]、车间调度[3]、图像处理[4]、机器人路径规划[5]、特征选择[6]等研究领域。但GWO算法存在收敛精度不高、收敛速度较慢和因搜索后期种群多样性的减少容易陷入局部最优等问题[7],为了提高GWO算法的性能,许多研究者提出了不同的改进意见。Liu等[8]提出了一种具有伪节点交叉操作和自适应控制参数a的改进算法,提高了算法在跳出局部最优和搜索精度上的优势。Gao等[9]引入自然对数的底数e建立非线性收敛因子和可变权重策略,提高了算法的搜索能力和降低陷入局部最优的概率。Rodríguez等[10]提出基于加权平均和不同的适应度加权以及模糊权重的不同分层运算变体,验证了分层算子模糊变量的GWO算法性能最好。Xu等[11]使用基于混沌映射的动态权重来引导灰狼进行搜索,克服了过早收敛到局部最优的缺点。韩太林等[12]提出改变候选解策略和动态权重因子的改进GWO算法,提高了灰狼个体多样性,降低了陷入局部最优的风险。Meng等[13]结合交叉算子和贪婪机制改进GWO算法,其中水平交叉算子细化首领狼,增强全局探索能力; 垂直交叉算子保持种群的多样性,防止陷入局部最优中。Long等[14]基于物理学中的折射原理,提出了折射学习的新算子,有助于GWO算法跳出局部最优。Yu等[15]将佳点集初始化策略和甲虫天线搜索机制引入GWO算法中,提高了算法初始化分散能力和全局探索能力。Mohammed等[16]将GWO算法和鲸鱼算法(whale optimization algorithm,WOA)相结合,协调算法全局探索和局部开发的平衡。

上述研究成果虽能够改善GWO算法的性能,但算法收敛精度不高和搜索后期易陷入局部最优的问题依旧存在。为进一步提高算法的收敛精度和收敛速度,解决搜索后期易陷入局部最优等问题,本研究提出一种融合多策略的黄金正弦灰狼优化算法(golden sine grey wolf optimization,G-GWO)。通过对三类基准测试函数的寻优测试结果对比,以及对Wilcoxon秩和检验的统计结果分析,验证了G-GWO算法在收敛精度和鲁棒性方面有显著的提高; 通过对BP神经网络(BP neural network,BPNN)建立板料工艺参数与质量参数的代理模型精度不足问题的优化结果对比表明,G-GWO算法在实际应用中较其他算法具有一定的优势。

1 GWO算法原理GWO算法在求解优化问题时,设灰狼种群数为N,搜索的空间维度为D,第i只灰狼在D维空间中的个体位置为Xi={Xi,1,Xi,2,…,Xi,D},i=1,2,…,N。将种群中的最优解记为α,次优解记为β,次次优解记为δ,其余解为ω。

灰狼在狩猎过程中包围猎物,对包围行为进行数学建模,提出了以下等式:

D=|CXP(t)-X(t)|。 (1)

X(t+1)=XP(t)-AD。 (2)

式(1)和(2)中:t为当前迭代次数; A和C均为系数向量; XP(t)为猎物的位置向量; X(t)为当前灰狼的位置向量; D为当前灰狼与猎物的距离; X(t+1)为灰狼位置的更新。

系数向量A和C的表达式为

A=2ar1-a。 (3)

C=2r2。 (4)

式(3)和(4)中:r1、r2为[0,1]中的随机向量; a为影响A变化的收敛因子,表达式为

a=2(1-t/(tmax))。 (5)

式(5)中:t为当前迭代次数; tmax为迭代的最大次数。

在狩猎过程中,利用α狼、β狼和δ狼的不同位置来预估猎物的位置,数学模型如下:

式(6)中:Dα、Dβ和Dδ分别为当前灰狼趋向于α、β、δ狼之间的近似距离; C1、C2和C3均为式(4)中定义的系数向量。

每只灰狼按照以下方式更新自己的位置:

式(7)和(8)中:Xα、Xβ、Xδ分别为α、β、δ狼的当前位置; X1、X2、X3分别为ω狼向α、β、δ狼的前进步长和方向; X(t+1)为ω狼的最后位置。

2 G-GWO算法2.1 收敛因子非线性调整策略GWO算法的探索和开发能力很大程度上依赖于A的取值,当|A|>1时,灰狼群体通过扩大搜索范围继续搜寻猎物,即全局搜索; 而当|A|<1时,灰狼群体则通过收缩搜索范围来进攻猎物,即局部开发。由式(3)可知,A的取值取决于收敛因子a的变化。因此,收敛因子a的取值影响着算法的全局搜索和局部开发能力。

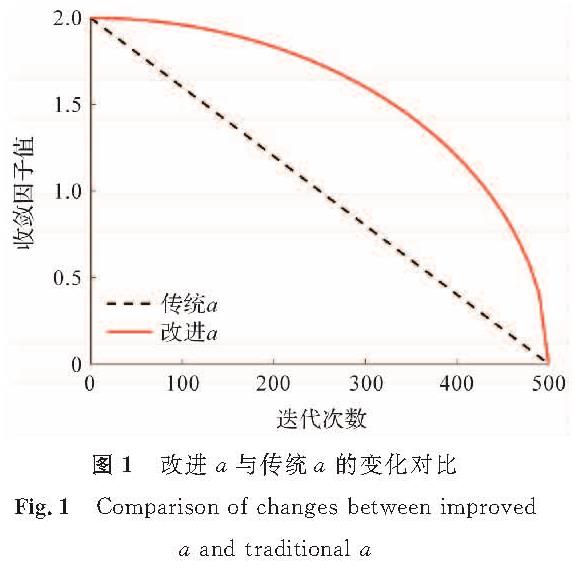

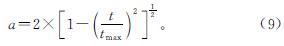

由式(5)可知,GWO算法中收敛因子a(传统a)由2线性递减至0,无法较好地实现“搜索前期应保持在大范围的搜索空间中搜索,后期则快速收敛至猎物位置”的目标[17]。为在迭代前期扩大搜索范围,迭代后期快速收敛,笔者提出一种新的非线性变化控制参数改进收敛因子a(改进a),改进a的表达式如式(9),改进a和传统a的变化对比如图1所示。

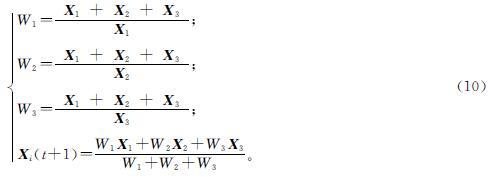

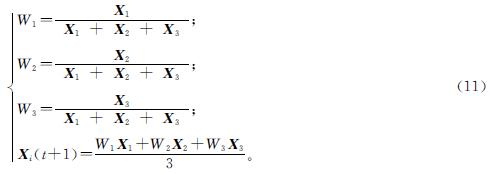

GWO算法将三类首领狼(α狼、β狼和δ狼)设置为同等重要程度,静态更新ω狼的位置(如式(8)所示),虽然这种位置更新方式对大多数常规问题有效,但无法满足高维、复杂的多模态问题求解。因此,笔者提出了基于步长欧氏距离原理的比例权重动态调整策略,改进后的比例权重动态调整策略表达式如式(10)和式(11)所示。

若|X2|>|X3|>|X1|或|X3|>|X2|>|X1|或|X3|>|X1|>|X2|,则

若|X1|>|X2|>|X3|或|X1|>|X3|>|X2|或|X2|>|X1|>|X3|,则

在式(10)和式(11)中,根据α、β和δ狼相对ω狼的位置分别计算三类首领狼的步长欧氏距离X1、X2和X3,动态调整ω狼的位置更新比例权重W1、W2和W3,使每次迭代过程中,离ω狼步长距离最近的α狼在下一步的位置更新过程中占有较大的权重,之后是离ω狼步长距离较近的β狼,并以离ω狼步长距离较远的δ狼的最低权重结束。

2.3 黄金正弦策略针对GWO算法在搜索后期由于种群多样性的减少而易陷入局部最优的问题,将黄金正弦策略[18]融合到GWO算法中,以降低算法搜索后期陷入局部最优的可能性。黄金正弦策略通过使用正弦函数对单位圆扫描来模拟搜索空间,并结合黄金分割系数进行迭代搜索的方式,更好地遍历算法搜索空间,防止算法陷入局部最优值。引入黄金正弦策略后的位置更新过程如下:

首先,将给定的N只狼在范围[lb,ub]中随机分布:

Xij=lb+r3(ub-lb),i∈[1,N],j∈[1,D]。 (12)

式(12)中:r3为[0,1]范围内的随机数。在第t次迭代中,第i只狼所在的位置为Xi={Xi,1,Xi,2,…,Xi,D},其中D为问题的维数; 之后将所有的灰狼存放在N行D列的矩阵P中。

其次,当所有灰狼完成随机分布后,引入黄金正弦策略计算在t+1次迭代中第i只狼的位置,其位置更新为

Xi G(t+1)=Xi(t)|sinr4|+r5sinr4|x1Pi(t)-x2Xi(t)|。 (13)

式(13)中:r4为[0,2π]范围内的随机数; r5为[0,π]范围内的随机数; Pi(t)为在第t次迭代中第i只狼的最优位置; x1和x2为黄金分割系数,其表达式为

式(14)中:τ=(51/2-1)/2为黄金分割数; a和b的初始默认值分别为-π和π。

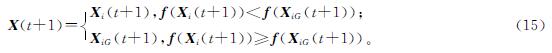

然后,对式(10)、式(11)和式(13)中所得到的两个更新位置预备解Xi(t+1)和Xi G(t+1)进行比较。

最后,将式(15)得到的下一个解的位置X(t+1)同X(t)进行比较,若新位置的适应度值比X(t)优,则按照X(t+1)进行位置更新; 反之则保持不动。

2.4 算法步骤综上所述,将收敛因子非线性调整策略、比例权重动态调整策略和黄金正弦策略融合,形成融合多策略的黄金正弦灰狼优化算法(G-GWO),算法步骤总结如下:

1)设置种群规模数N,最大迭代次数tmax,搜索维度D; 生成a、A和C等参数,随机初始化灰狼种群。

2)计算种群中所有灰狼个体的适应度值,并进行排序,记录排列前三的适应度并记录位置为Xα、Xβ和Xδ。

3)通过式(9)更新非线性收敛因子a,式(3)和式(4)更新系数向量A和C的值。

4)通过式(6)和式(7)及步长欧氏距离动态调整策略式(10)和式(11)建立第一个预备解Xi(t+1)。

5)通过黄金正弦策略的式(13)建立另一个预备解Xi G(t+1),通过式(15)比较两个预备解,选择较优的值与X(t)比较,择优作为灰狼的位置更新。

6)判断是否满足结束条件,若达到预定的最大迭代次数tmax,则停止计算; 否则重复循环跳转至2)。

7)输出全局最优解。

3 试验仿真结果与分析3.1 试验环境及参数设置为测试G-GWO算法的性能,选择文献[1]中的单峰、多峰和固定维度多峰三类基准测试函数进行仿真试验,三类基准测试函数见表1。试验运行环境为Intel(R)Core(TM)i7-77700HQ CPU,主频2.80 GHz,内存8 GB,Win10 64位操作系统; 运行软件为MatLabR2018b。

为保证试验的无偏性,灰狼总个数设定为30,总迭代次数设置为500次,所有试验独立运行30次,通过试验比较得到的平均值和标准差值。

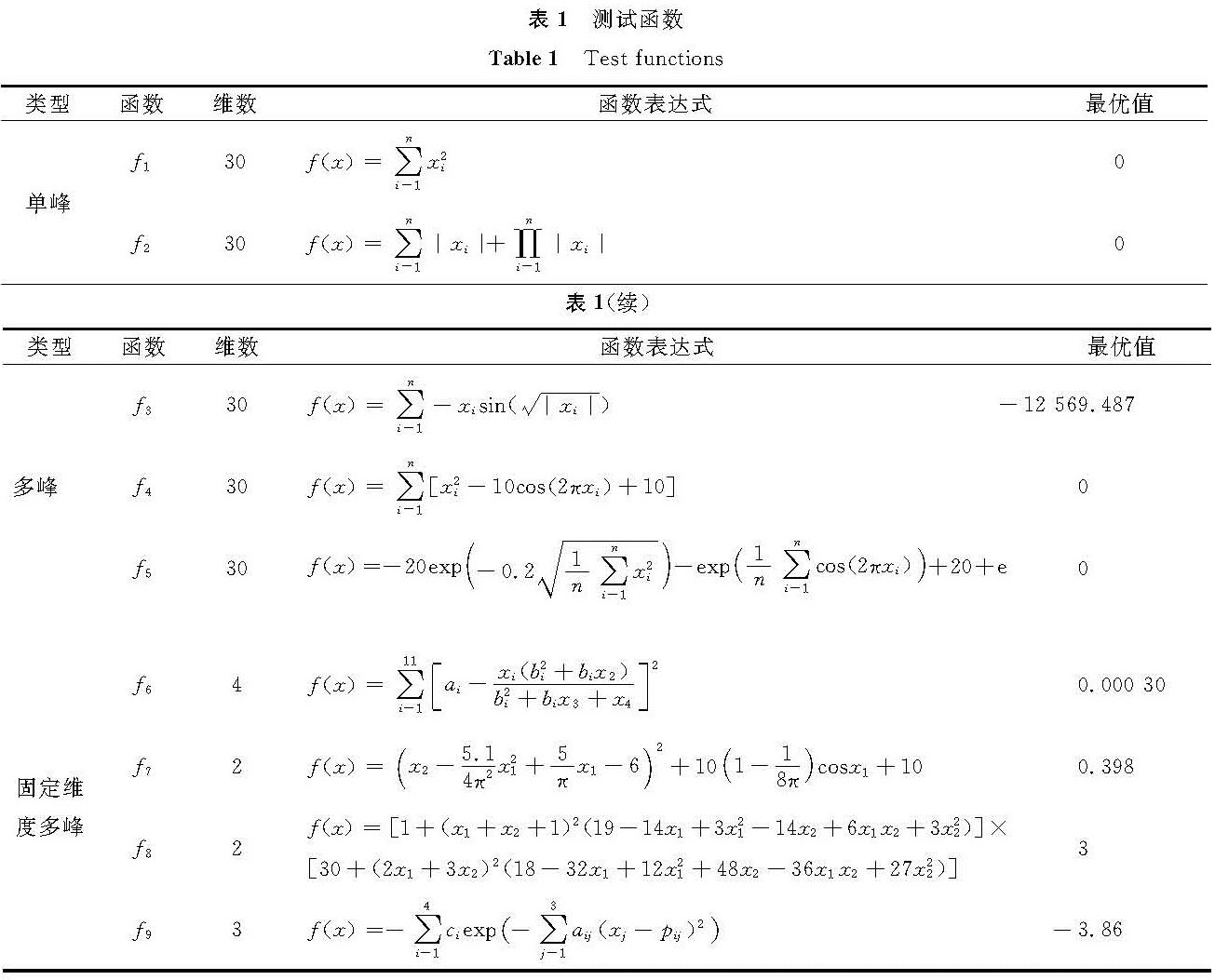

3.2 不同改进策略寻优性能对比

为验证改进策略的有效性,将GWO算法与仅采用非线性收敛因子调整策略的GWO1算法、仅采用动态比例权重调整策略的GWO2算法、仅引入黄金正弦策略的GWO3算法和G-GWO算法进行比较。测试本研究提出的三种不同的改进策略单独作用时的情况,使用三类基准测试函数进行仿真试验,结果见表2,其中平均值和标准差的较优值加粗展示(下同)。

表2 不同改进策略对算法的影响比较

Table 2 Comparison of influencesamong different improvement strategies on algorithms

由表2可知,对于单峰函数f1和f2,GWO1、GWO2和GWO3算法的平均值和标准差均比GWO算法更接近于理论最优值0。对于多峰函数f3、f4和f5,GWO1和GWO2算法在f4和f5的平均值和标准差值比GWO算法更接近于理论最优值,GWO3算法的平均值和标准差均比GWO算法更接近于理论最优值(f3的最优平均值为-12 569.487,f4与f5的最优平均值为0)。对于固定维度多峰函数f6、f7、f8和f9,GWO3算法在f6的平均值和标准差结果最优(f6的最优平均值为0.000 30),GWO、GWO1、GWO2和GWO3算法在f7和f9平均值和标准差值较为接近,在f8中均收敛到理论最优值3。融合三种策略的G-GWO算法除了在多峰函数f6的平均值仅次于GWO3算法外(优于其他算法),对其他8个测试函数的收敛精度均为最优,且在单峰函数f1和多峰函数f4收敛到理论最优值0,在固定维度多峰函数f8收敛到理论最优值3,相较于GWO算法而言,G-GWO算法的标准差值更小,对三类基准测试函数的鲁棒性均有明显提升。由此可见:在对提升单峰函数、多峰函数与固定维度多峰函数的收敛精度和鲁棒性上,三种改进策略均是有效的。

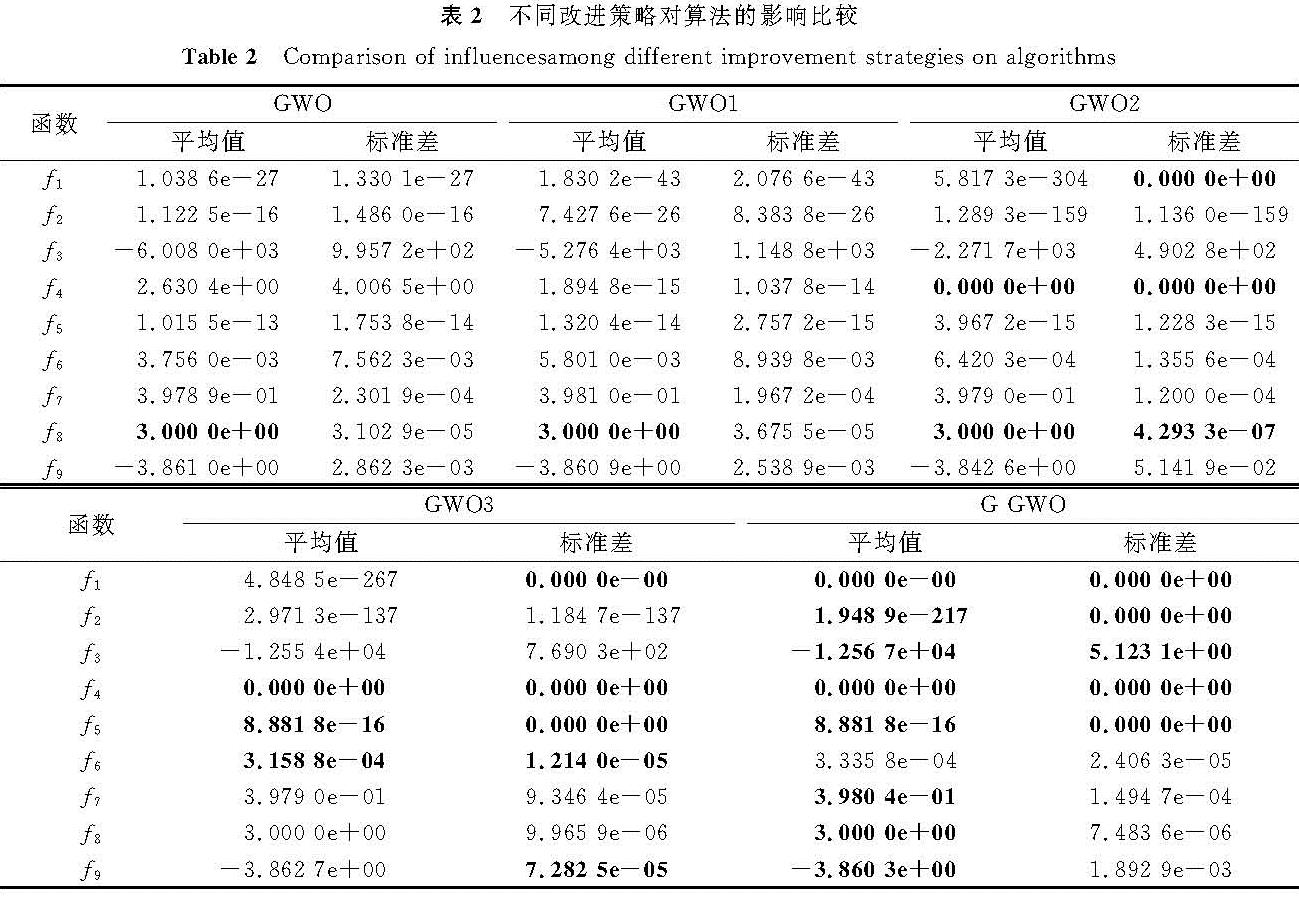

3.3 与其他智能优化算法对比将G-GWO算法分别与黄金正弦算法(golden sine algorithm,Golden-SA)[18]、WOA算法[19]和粒子群算法(particle swarm optimization,PSO)[20]进行比较,其中设置PSO参数为wmax=0.9、wmin=0.2和c1=c2=2,其余的参数设置则参照上述相关文献,试验结果见表3。

由表3可知,对于单峰函数f1和f2,G-GWO算法的平均值分别为0和1.948 9e-217,标准差值均为0,明显小于Golden-SA、WOA和PSO算法的平均值和标准差值,G-GWO算法在单峰函数的收敛精度和鲁棒性较优。对于多峰函数f3、f4和f5,G-GWO算法的平均值分别为-1.256 7e+04、0和8.881 8e-16,且在f4和f5的标准差值为0,与Golden-SA算法相比,两者在f3的平均值结果相近,在f4和f5中测试结果一致; 与WOA算法相比,两者在f4均收敛到理论最优值0,但在f3和f5中,G-GWO算法的平均值更接近理论最优值,具有更高的收敛精度,同时,G-GWO算法的标准差值在f3和f5均小于WOA算法,具有较优的鲁棒性; 与PSO算法相比,G-GWO算法的平均值和标准差值明显较优,其收敛精度和鲁棒性均有显著优势。对于固定维度多峰函数f6、f7、f8和f9,G-GWO算法的平均值分别为3.335 8e-04、3.980 4e-01、3.000 0e+00、-3.860 3e+00,均收敛到理论最优值附近(f6的最优平均值为0.000 30,f7的最优平均值为0.398,f8的最优平均值为3,f9的最优平均值为-3.86),较Golden-SA算法均有明显优势; 与WOA和PSO算法相比,G-GWO算法在f6、f7和f9收敛精度更高,在f8中则均收敛到理论最优值。

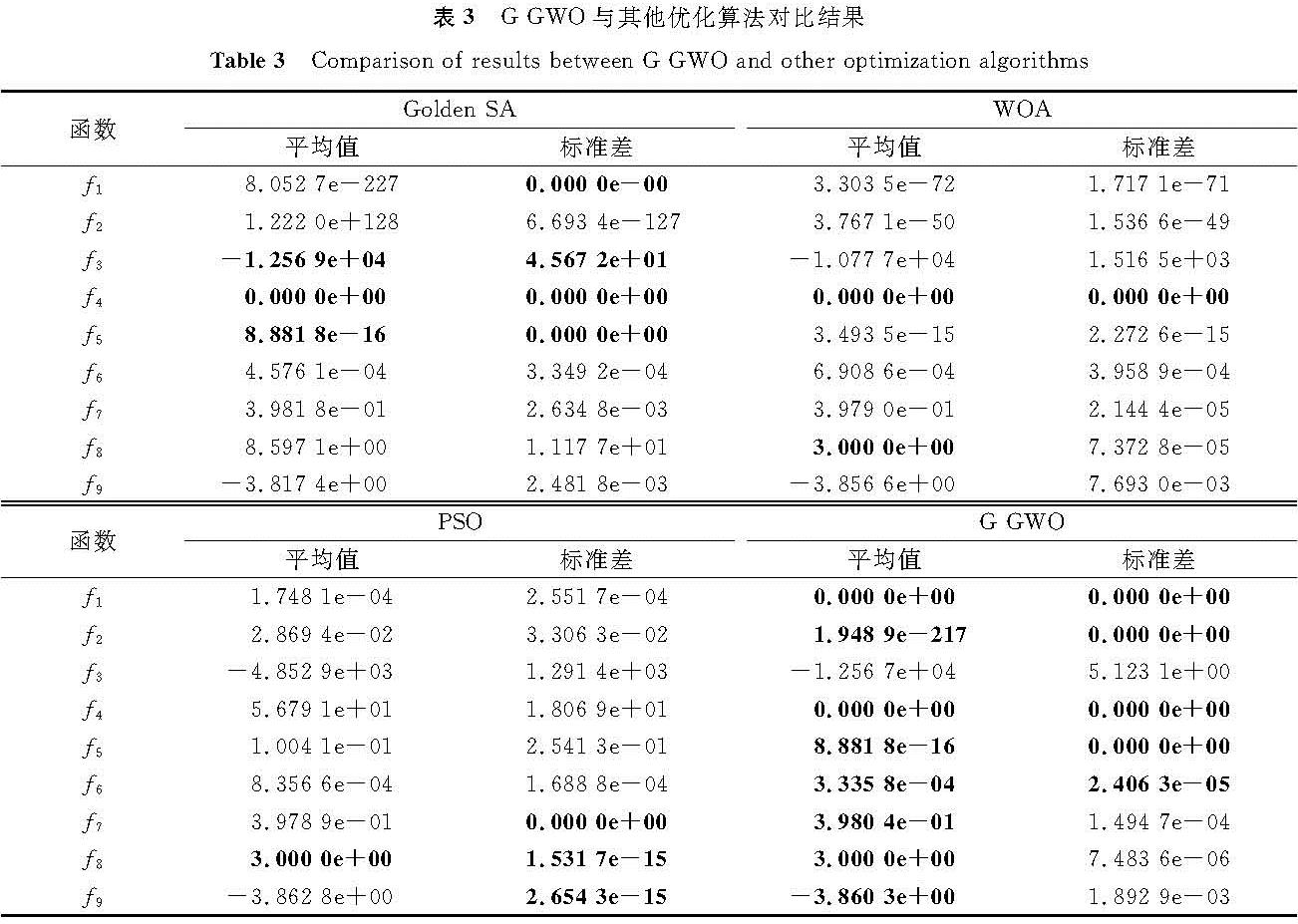

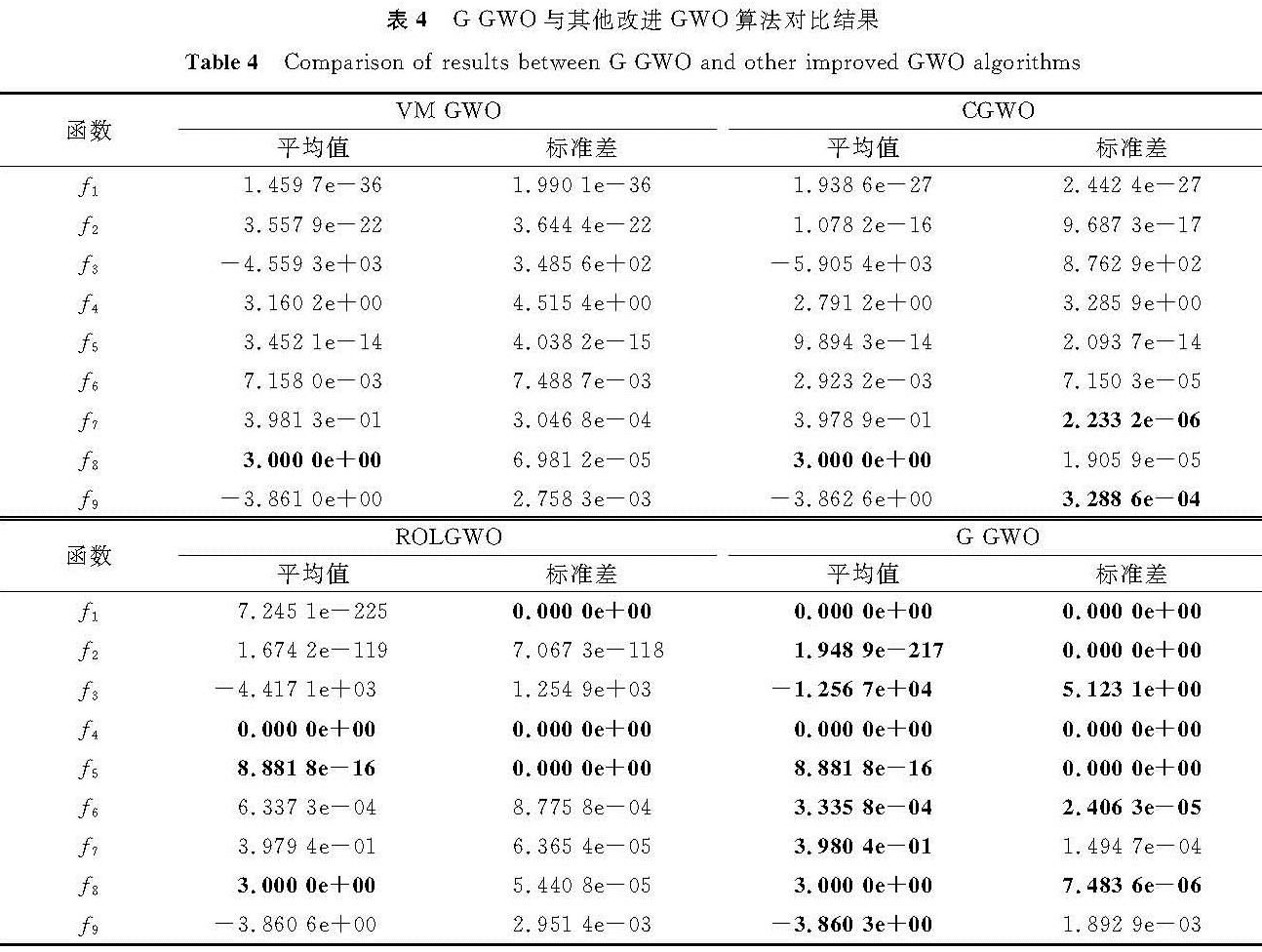

3.4 与其他改进GWO算法对比选取具有变权重的改进灰狼优化算法(variable weights grey wolf optimization algorithm,VM-GWO)[9]、自适应正态云模型的灰狼优化算法(adaptive normal cloud model grey wolf optimization algorithm,CGWO)[21]随机对立学习的灰狼优化算法(random opposition-based learning grey wolf optimization algorithm,ROLGWO)[22]三种改进GWO算法进行对比,其中设置CGWO算法的参数为ω=0.3、τ=1和ξ=2,其余的参数设置则参照上述相关文献,试验结果见表4。

由表4可知,对于单峰函数f1和f2,与VM-GWO、CGWO和ROLGWO算法相比,G-GWO算法的平均值更接近理论最优值0,标准差值更小,G-GWO算法的收敛精度和鲁棒性均有明显的优势。对于多峰函数f3、f4和f5,与VM-GWO和CGWO算法相比,G-GWO算法的平均值更接近于理论最优值,标准差更小; 与ROLGWO算法相比,G-GWO算法在f3的平均值和标准差均比ROLGWO算法接近于理论最优值,而在f4和f5中的测试结果相同。对于固定维度多峰函数f6、f7、f8和f9,与VM-GWO算法和ROLGWO算法相比,三者仅在f8中得到相同的平均值,其余则G-GWO算法的平均值和标准差更优; 与CGWO算法相比,G-GWO算法在f6、f7和f9中的平均值明显更接近理论最优值,在f8中两者均收敛到理论最优值。

3.5 Wilcoxon秩和检验分析为了评估G-GWO算法的性能,将G-GWO算法与其他7种算法在三类测试函数的运行结果进行Wilcoxon秩和检验,并计算p值,其中选择显著性水平0.05,使用+/≈/-来表明算法优于、相似或者差于比较的算法,N/A表示算法结果接近,无法进行显著性判断。测试函数的Wilcoxon秩和检验结果见表5。

由表5可知,G-GWO算法的Wilcoxon秩和检验结果p值大部分小于0.05,统计结果表明:相比其他7种常用优化算法,G-GWO算法对三类测试函数的寻优性能具有显著优势。

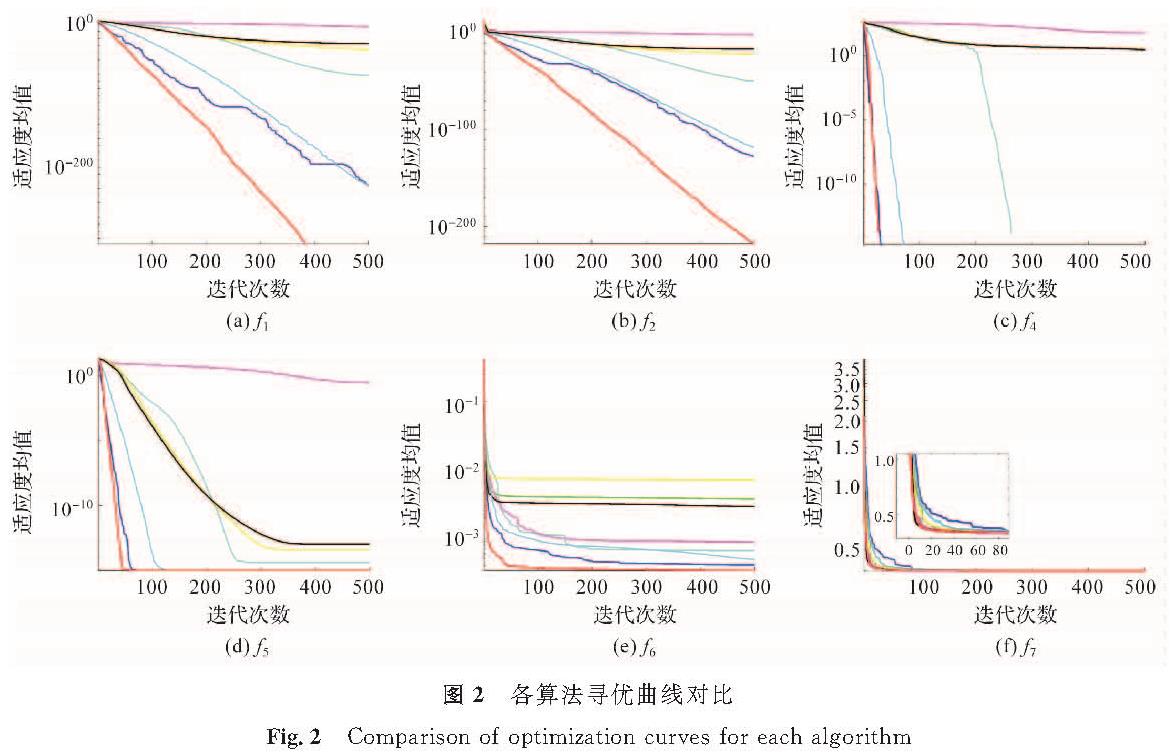

3.6 收敛性分析为了直观地反映G-GWO算法的收敛性能,选取GWO、Golden-SA、WOA、PSO、VM-GWO、CGWO、ROLGWO和G-GWO等8种算法对单峰函数f1、f2,多峰函数f4、f5和固定维度多峰函数f6、f7作为典型函数进行收敛性分析,得到适应度均值随迭代次数的变化曲线,各算法寻优曲线对比如图2所示。

由图2可知,G-GWO算法在单峰函数f1和多峰函数f4中能够快速地收敛到理论最优值,且不存在明显的停滞,并在单峰函数f2、多峰函数f5及固定维度多峰函数f6和f7中快速收敛至较优值并保持稳定,与其他算法相比具有明显优势。GWO、PSO、VM-GWO和CGWO算法在三类基准测试函数中存在不同程度的停滞,收敛精度低; Golden-SA、WOA和ROLGWO算法除了在多峰函数f4外,其他基准测试函数中均陷入局部最优值。综合图2结果分析,G-GWO算法在收敛速度和收敛精度上较其他算法具有较大的优势。

4 G-GWO算法对板料冲压成形的代理模型精度优化研究为验证G-GWO算法在实际应用中的有效性,对建立的板料冲压成形的BP神经网络代理模型精度进行优化,并将G-GWO算法优化结果与GWO、Golden-SA、WOA、PSO、VM-GWO、CGWO和ROLGWO算法的结果进行对比。

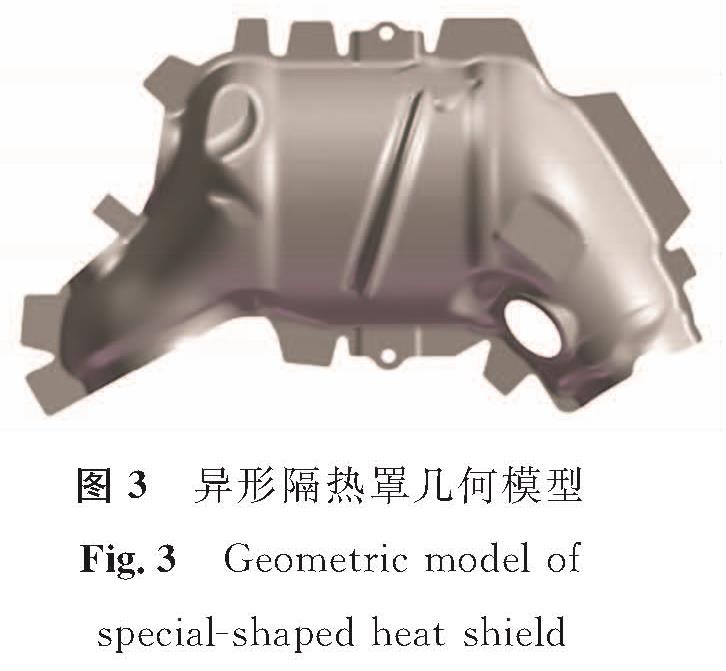

4.1 冲压件简介本文选取异形薄壁不锈钢隔热罩为研究对象,其几何模型见图3,三维尺寸为378 mm×227 mm×76 mm,冲压件的厚度为0.25 mm。

板坯材料所使用的是SUS304不锈钢,其材料性能参数如下:屈服强度为239 MPa,抗拉强度为520 MPa,弹性模量为2.1×105 MPa,泊松比为0.28,硬化指数为0.40。

4.2 成形质量与目标

将冲压件的最大减薄率和最大增厚率两个质量参数作为优化目标,优化目标函数如下:

Y1=min y1; (15)

Y2=min y2。 (16)

式(15)~(16)中:Y1和Y2为目标函数; y1为冲压件最大减薄率; y2为最大增厚率。

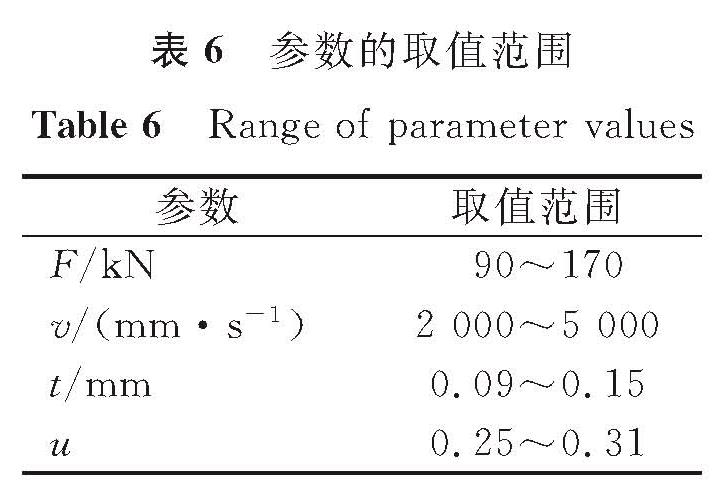

在影响冲压成形质量的主要工艺参数中,压边力(F)、冲压速度(v)、模具间隙(t)和摩擦系数(u)的取值范围见表6。

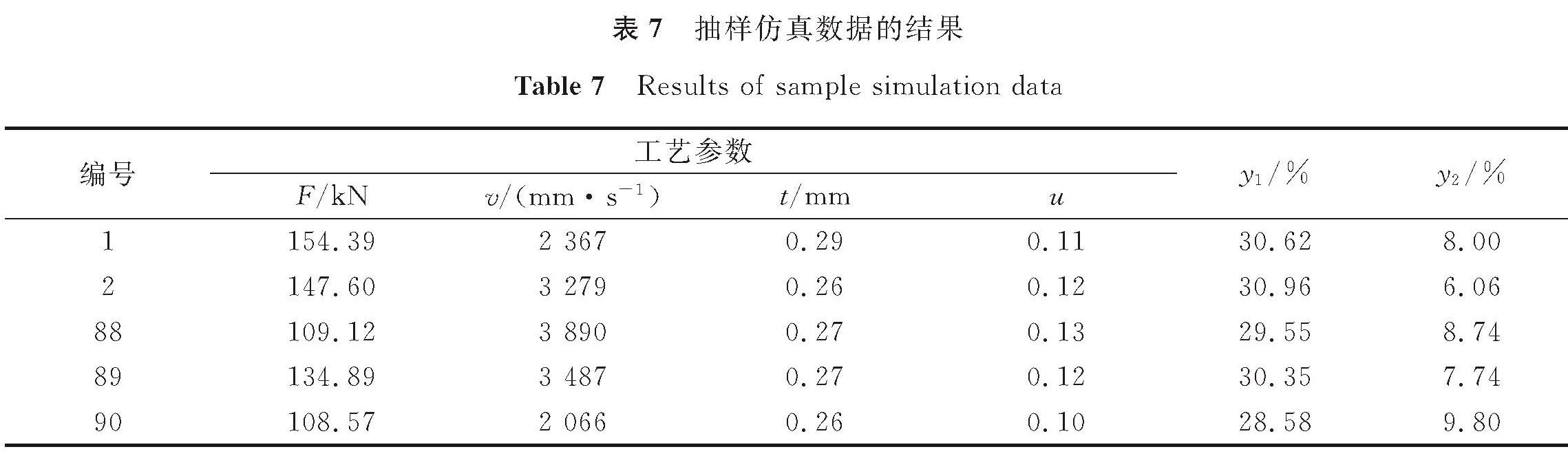

4.3 试验设计使用拉丁超立方抽样法(latin hypercube sampling,LHS)抽取样本,在压边力、冲压速度、模具间隙和摩擦系数4个优化参数的取值范围内抽取满足数值拟合要求的90组试验参数,使用有限元软件Dynaform进行仿真试验,得到各组在抽样点条件下的冲压件最大减薄率和最大增厚率,并通过BP神经网络采用单输出的拟合方式[23],即对隔热罩异形件的质量参数最大减薄率和最大增厚率为输出分别建模。将90个样本中的80%作为网络训练数据,余下20%作为网络预测数据,截取前两组和后三组的抽样仿真数据的结果,见表7。

4.4 精度分析

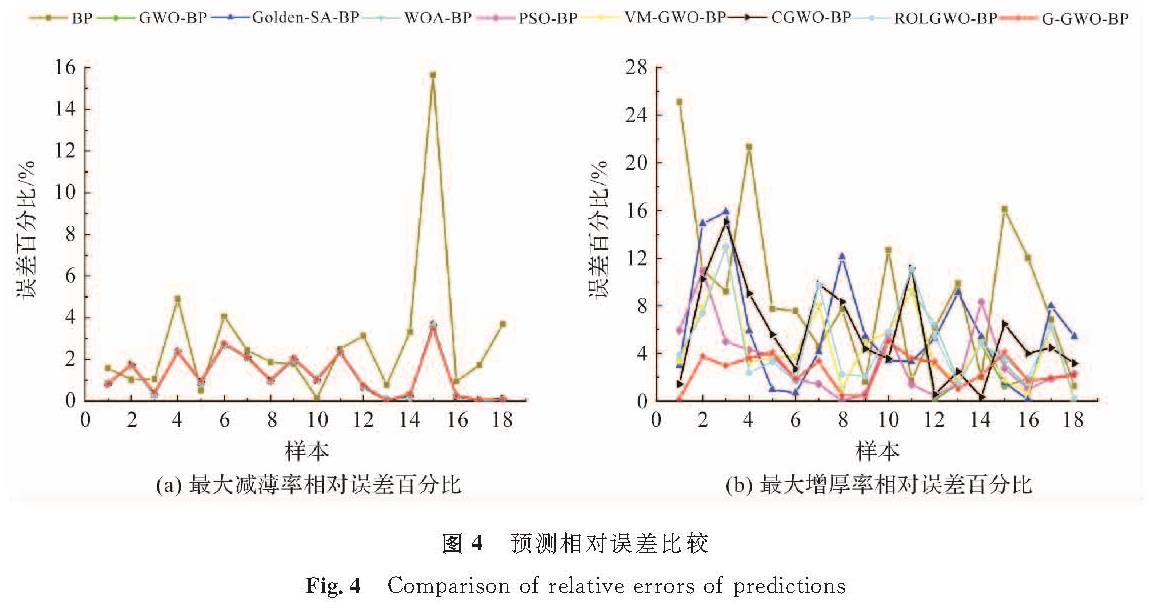

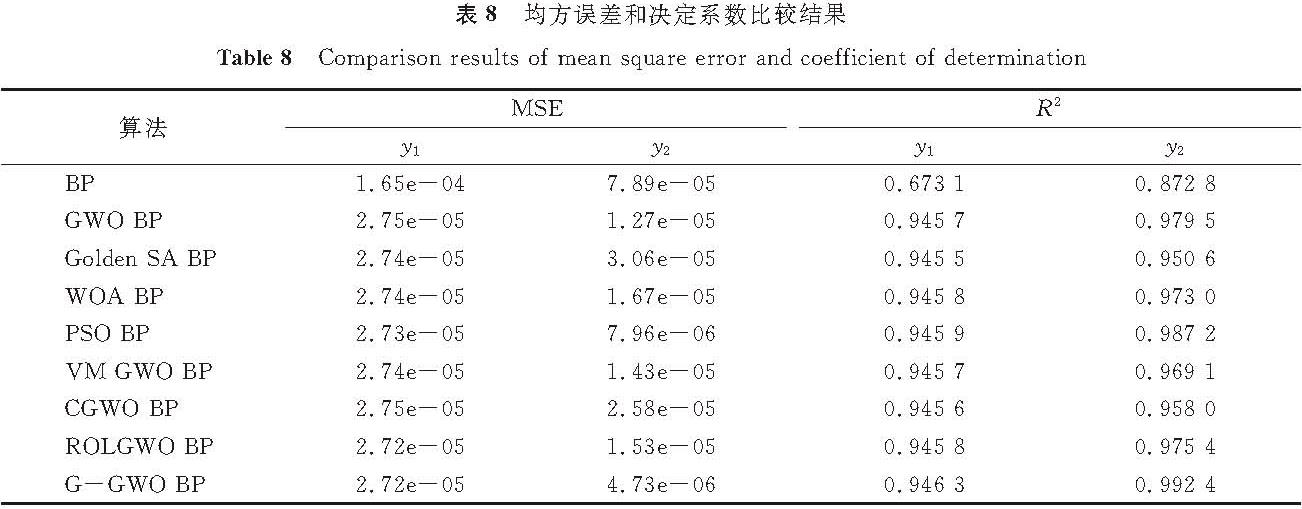

分别使用G-GWO和其他7种算法优化BP神经网络的权值和阈值,建立4个工艺参数与最大减薄率和最大增厚率的代理模型。通过均方误差和决定系数来检验BP神经网络模型的精度。其中,最大减薄率和最大增厚率的预测相对误差比较如图4所示,均方误差(mean square error,MSE)和决定系数(coefficient of determination,R2)比较结果见表8。

由图4(a)可知,G-GWO算法优化的代理模型精度较高,最大相对误差为3.47%; 由图4(b)可知,G-GWO算法优化的代理模型的最大相对误差为4.99%,明显优于其他算法。综合图4分析,G-GWO算法优化的代理模型的相对误差值均小于5%,训练的代理模型精度高。由表8可知,G-GWO算法优化的最大减薄率代理模型的MSE和R2分别为2.72e-05和0.946 3,最大增厚率代理模型的MSE和R2分别为4.73e-06和0.992 4,G-GWO优化BP神经网络的代理模型精度明显优于其他算法,预测精度高,建立的高精度G-GWO算法优化BP神经网络代理模型可以满足后续对冲压工艺成形优化设计的要求。综合以上结果,G-GWO算法在板料冲压成形的代理模型精度优化问题上具有一定的优越性。

5 结 论本研究在GWO算法的基础上,以提高GWO算法的收敛精度、收敛速度和跳出局部最优为目的,提出了一种融合多策略的黄金正弦灰狼优化算法(G-GWO),得出如下结论。

1)引入非线性收敛因子和动态比例权重策略,协调算法全局探索和局部开发的能力,提高算法的收敛速度; 结合黄金正弦策略更新灰狼位置,提高算法在搜索后期处理局部最优的能力,采用多种策略融合可以使算法寻优性能更加良好。通过三类基准测试函数进行寻优测试,从平均值、标准差及收敛曲线的结果表明,G-GWO算法具有较优的收敛精度和鲁棒性,以及快速收敛的能力; 并进行Wilcoxon秩和检验,从统计学的角度验证了G-GWO算法的显著优势。

2)将G-GWO算法与其他7种优化算法应用于建立板料冲压成形的BP神经网络代理模型中,其中G-GWO算法建立的最大减薄率和最大增厚率代理模型误差均小于5%,具有显著优势,验证了G-GWO算法在实际优化问题中的有效性。

未来,通过将不同的灰狼位置更新模型以及结合各种优秀的算法来增强GWO算法的搜索能力,同时也将致力研究应用于更多的领域。

- [1] MIRJALILI S, MIRJALILI S M, LEWIS A. Grey wolf optimizer[J].Advances in Engineering Software,2014,69:46.

- [2] MAKHADMEH S N, KHADER A T, AL-BETAR M A, et al. A novel hybrid grey wolf optimizer with min-conflict algorithm for power scheduling problem in a smart home[J].Swarm and Evolutionary Computation,2021,60:100793.

- [3] JIANG T H, ZHANG C, ZHU H Q, et al. Energy-efficient scheduling for a job shop using grey wolf optimization algorithm with double-searching mode[J].Mathematical Problems in Engineering,2018,2018:1.

- [4] LIU Y Y, SUN J H, YU H Y, et al. An improved grey wolf optimizer based on differential evolution and OTSU algorithm[J].Applied Sciences,2020,10(18):6343.

- [5] KUMAR R, SINGH L, TIWARI R. Path planning for the autonomous robots using modified grey wolf optimization approach[J].Journal of Intelligent & Fuzzy Systems,2021,40(5):9453.

- [6] PURUSHOTHAMAN R, RAJAGOPALAN S P, DHANDAPANI G. Hybridizing gray wolf optimization(GWO)with grasshopper optimization algorithm(GOA)for text feature selection and clustering[J].Applied Soft Computing,2020,96:106651.

- [7] YAN F, XU X L, XU J Z. Grey wolf optimizer with a novel weighted distance for global optimization[J].IEEE Access,2020,8:120173.

- [8] LIU X, WANG N. A novel gray wolf optimizer with RNA crossover operation for tackling the non-parametric modeling problem of FCC process[J].Knowledge-Based Systems,2021,216:106751.

- [9] GAO Z M, ZHAO J. An improved grey wolf optimization algorithm with variable weights[J].Computational Intelligence and Neuroscience,2019,2019:2981282.

- [10] RODRÍGUEZ L, CASTILLO O, SORIA J, et al. A fuzzy hierarchical operator in the grey wolf optimizer algorithm[J].Applied Soft Computing,2017,57:315.

- [11] XU J Z, YAN F, ALA O G, et al. Chaotic dynamic weight grey wolf optimizer for numerical function optimization [J].Journal of Intelligent & Fuzzy Systems,2019,37(2):2367.

- [12] 韩太林,张延雪,王啸,等.改进型灰狼算法在热电偶动态补偿中的应用[J].控制与决策,2021,36(1):61.

- [13] MENG A B, ZENG C, WANG P, et al. A high-performance crisscross search based grey wolf optimizer for solving optimal power flow problem[J].Energy,2021,225:120211.

- [14] LONG W, WU T B, CAI S H, et al. A novel grey wolf optimizer algorithm with refraction learning[J].IEEE Access,2019,7:57805.

- [15] YU X W, HUANG L P, LIU Y, et al. WSN node location based on beetle antennae search to improve the grey wolf algorithm[J].Wireless Networks,2022,28(2):539.

- [16] MOHAMMED H, RASHID T. A novel hybrid GWO with WOA for global numerical optimization and solving pressure vessel design[J].Neural Computing and Applications,2020,32(18):14701.

- [17] 李全耀,沈艳霞.一种基于教与学的混合灰狼优化算法[J].控制与决策,2022,37(12):3190.

- [18] TANYILDIZI E, DEMIR G. Golden sine algorithm:a novel math-inspired algorithm[J].Advances in Electrical and Computer Engineering,2017,17(2):71.

- [19] MIRJALILI S, LEWIS A. The whale optimization algorithm[J].Advances in Engineering Software,2016,95:51.

- [20] EBERHART R, KENNEDY J. A new optimizer using particle swarm theory[C]//Proceedings of the Sixth International Symposium on Micro Machine and Human Science. Nagoya, Japan:LEEE,1995:39.

- [21] 张铸,饶盛华,张仕杰.基于自适应正态云模型的灰狼优化算法[J].控制与决策,2021,36(10):2562.

- [22] LONG W, JIAO J J, LIANG X M, et al. A random opposition-based learning grey wolf optimizer[J].IEEE Access,2019,7:113810.

- [23] 肖展开,梅益,罗宁康,等.基于神经网络航空发动机曲轴加工工艺设计优化[J].锻压技术,2022,47(6):35.

图 1 改进a与传统a的变化对比

Fig.1 Comparison of changes between improved a and traditional a

图 1 改进a与传统a的变化对比

Fig.1 Comparison of changes between improved a and traditional a